T5Gemma 2 guida completa: leggere e capire a lungo raggio

T5Gemma 2 rappresenta l'ultima frontiera dei modelli multimodali open source di Google DeepMind, progettato per superare i limiti di risoluzione e lunghezza del contesto nell'elaborazione di immagini e testo. Questo modello ottimizza l'architettura encoder-decoder per eccellere in compiti complessi di document understanding e ragionamento visivo su sequenze di dati estremamente estese.

- Paper originale: T5Gemma 2: Seeing, Reading, and Understanding Longer

- Data di rilascio: 16 Dicembre 2025

- Link al Paper: arXiv:2512.14856

Che cos'è T5Gemma 2 e perché è importante (guida completa)

In questa guida a T5Gemma 2 analizzeremo come questo nuovo modello di Vision-Language (VLM) si posizioni come uno strumento fondamentale per chiunque debba analizzare documenti densi e immagini ad alta risoluzione. A differenza dei modelli precedenti che spesso faticano a mantenere la coerenza su testi lunghi o a leggere caratteri molto piccoli, T5Gemma 2 introduce innovazioni strutturali per gestire entrambi gli aspetti simultaneamente.

Che cos'è T5Gemma 2 in parole semplici?

T5Gemma 2 è un modello di intelligenza artificiale multimodale che agisce come un "occhio" e un "cervello" altamente specializzati nella lettura. Immaginate di avere un assistente che non solo guarda una foto, ma è in grado di leggere ogni singola nota a piè di pagina in un documento legale di cento pagine o di analizzare grafici complessi con estrema precisione.

Utilizza la potenza della famiglia di modelli Gemma 2 di Google, integrandola in una struttura che separa la fase di comprensione (encoder) dalla fase di generazione della risposta (decoder). Questo approccio lo rende particolarmente efficace nel trasformare stimoli visivi grezzi in risposte testuali strutturate e accurate.

Perché T5Gemma 2 è rilevante oggi?

Nel panorama attuale, molti modelli multimodali soffrono di un collo di bottiglia legato alla risoluzione: per risparmiare risorse computazionali, riducono la qualità dell'immagine, perdendo dettagli cruciali come il testo piccolo. T5Gemma 2 affronta questo problema permettendo una gestione dinamica e ad alta risoluzione degli input visivi.

Inoltre, la capacità di gestire un context window molto ampio permette al modello di "ricordare" informazioni viste all'inizio di un lungo documento mentre risponde a domande poste alla fine. Questa caratteristica è vitale per applicazioni aziendali, legali e di ricerca dove la precisione del dato non può essere sacrificata.

Come si collega T5Gemma 2 ai modelli che già conosci?

T5Gemma 2 è l'evoluzione diretta del precedente T5Gemma, ma eredita le ottimizzazioni architettoniche introdotte con Gemma 2, come le sliding window attention e le logit soft-capping. Si distingue dai modelli decoder-only (come GPT-4 o Llama) perché mantiene la natura encoder-decoder tipica della serie T5.

Rispetto a modelli come PaliGemma, T5Gemma 2 è progettato per compiti di ragionamento più profondi e per una comprensione testuale superiore. Mentre altri modelli si concentrano sulla descrizione generica di scene, questo sistema punta tutto sul "reading" e sul "document understanding" di alta precisione.

GitHub: non disponibile (solitamente rilasciato nel repository di Google Research)

Dataset: non disponibile

T5Gemma 2 spiegato più in dettaglio

Entrare nei meccanismi tecnici di T5Gemma 2 significa comprendere come Google abbia integrato un vision encoder avanzato con il backbone linguistico di Gemma 2. La scelta di un'architettura encoder-decoder non è casuale: questa configurazione permette di separare nettamente l'elaborazione dei pixel dalla generazione dei token, ottimizzando il throughput durante l'inferenza.

Architettura e componenti chiave

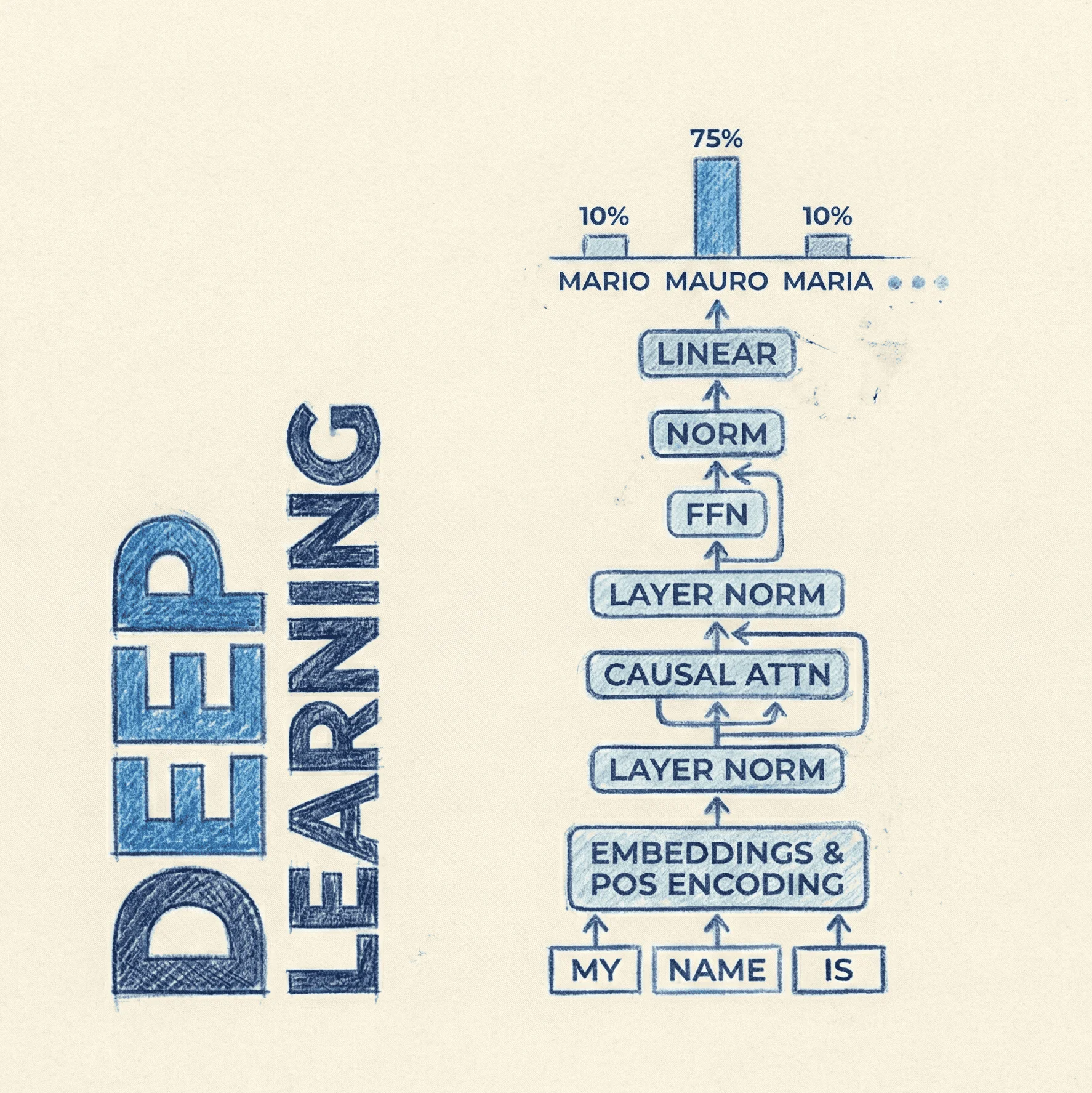

L'architettura si basa su un vision encoder (spesso basato su SigLIP) che trasforma l'immagine in una serie di embedding visivi. Questi vengono poi proiettati nello spazio dei token del modello linguistico Gemma 2. La vera innovazione risiede nel modo in cui questi token visivi vengono integrati con il testo, permettendo al modello di processare immagini a risoluzioni variabili senza distorsioni eccessive.

Il componente decoder utilizza le tecniche di addestramento di Gemma 2 per generare testo fluido e coerente. L'integrazione di meccanismi di cross-attention permette al decoder di interrogare costantemente le informazioni estratte dall'encoder visivo, garantendo che ogni parola generata sia strettamente ancorata a ciò che il modello "vede" nell'immagine o nel documento.

Gestione dell'alta risoluzione e del contesto lungo

Uno dei problemi principali nei VLM è la tokenization delle immagini: troppi token visivi rallentano il sistema, troppo pochi perdono dettagli. T5Gemma 2 utilizza una strategia di patching intelligente che divide l'immagine in sotto-sezioni, permettendo al modello di focalizzarsi su dettagli minuscoli come le cifre in una tabella finanziaria o le clausole in un contratto.

Per quanto riguarda il contesto, il modello supporta sequenze molto lunghe, rendendolo ideale per il "long-form document understanding". Questo significa che può processare PDF multipagina come se fossero un'unica entità coerente, collegando informazioni visive presenti a pagina 1 con domande testuali derivanti da pagina 50.

Training e ottimizzazione

Il training di T5Gemma 2 avviene in più fasi: un pre-training multimodale su larga scala seguito da un supervised fine-tuning (SFT) su dataset specifici per il document understanding. Google ha utilizzato una mixture di dati che include OCR (Optical Character Recognition), comprensione di grafici, diagrammi e screenshot di pagine web.

Questa dieta di dati bilanciata permette al modello di evitare il fenomeno dell'oblio catastrofico, mantenendo ottime capacità di ragionamento logico mentre apprende nuove abilità visive. Le tecniche di ottimizzazione usate permettono inoltre di mantenere i pesi del modello entro dimensioni gestibili per il deployment su hardware moderno, nonostante la complessità architettonica.

Confronto con le baseline

Nei benchmark standard come DocVQA, InfoVQA e TextVQA, T5Gemma 2 mostra miglioramenti significativi rispetto al suo predecessore T5Gemma e a modelli concorrenti di taglia simile. La capacità di catturare dettagli testuali in contesti visivi complessi lo pone davanti a modelli generalisti che spesso ignorano il testo "piccolo" o non strutturato.

Rispetto a modelli come Gemini 1.5 Flash (nelle sue versioni più piccole), T5Gemma 2 offre un'alternativa open-weights che permette maggiore flessibilità per i ricercatori. Sebbene i modelli chiusi possano avere picchi di performance superiori, T5Gemma 2 eccelle nel rapporto tra efficienza computazionale e accuratezza nella lettura dei documenti.

Limiti e punti aperti

Nonostante le innovazioni, T5Gemma 2 presenta ancora dei limiti. Il costo computazionale per processare immagini ad altissima risoluzione con contesti lunghi rimane elevato. Inoltre, come tutti i modelli basati su LLM, esiste il rischio di "hallucinations" visive, dove il modello potrebbe leggere erroneamente un numero se la qualità dell'immagine originale è estremamente degradata.

Un altro punto aperto riguarda la gestione dei video. Sebbene sia eccellente con immagini statiche e documenti, l'estensione a flussi video temporali richiede ulteriori ottimizzazioni per gestire la coerenza tra i frame. Attualmente, il focus rimane sulla "lettura" profonda piuttosto che sulla comprensione dinamica di scene in movimento.

Licenze d'uso e disponibilità

T5Gemma 2 segue la filosofia dei modelli "Gemma", con una licenza che permette l'uso commerciale e la ricerca, soggetta ai termini di utilizzo di Google. I pesi del modello e il codice per l'inferenza sono solitamente resi disponibili su piattaforme come Hugging Face, facilitando l'integrazione in pipeline esistenti di data processing.