Sigma-MoE-Tiny guida completa: Efficienza e Performance con 500M parametri

Solo 1 esperto attivo?!

Sigma-MoE-Tiny migliora l'efficienza dei modelli linguistici, dimostrando che è possibile avere la "conoscenza" di un modello large (20 miliardi di parametri) ma il "costo" di inferenza di un modello small (0.5 miliardi). In questa guida analizzeremo come questo modello, rilasciato a fine 2025, risolva i problemi storici dei Mixture-of-Experts (MoE) grazie a un innovativo sistema di routing e a una strategia di training progressiva.

Che cos'è Sigma-MoE-Tiny in parole semplici?

Immagina di avere una biblioteca con 20.000 libri (i parametri totali del modello), ma per rispondere a una singola domanda ti sia permesso di consultarne solo uno o due specifici (i parametri attivi). Sigma-MoE-Tiny funziona esattamente così: è un modello di linguaggio basato sull'architettura Mixture-of-Experts (MoE) che possiede una vasta capacità di memoria (20 miliardi di parametri) ma attiva solo una frazione minuscola del suo cervello (0.5 miliardi) per ogni singola parola che genera.

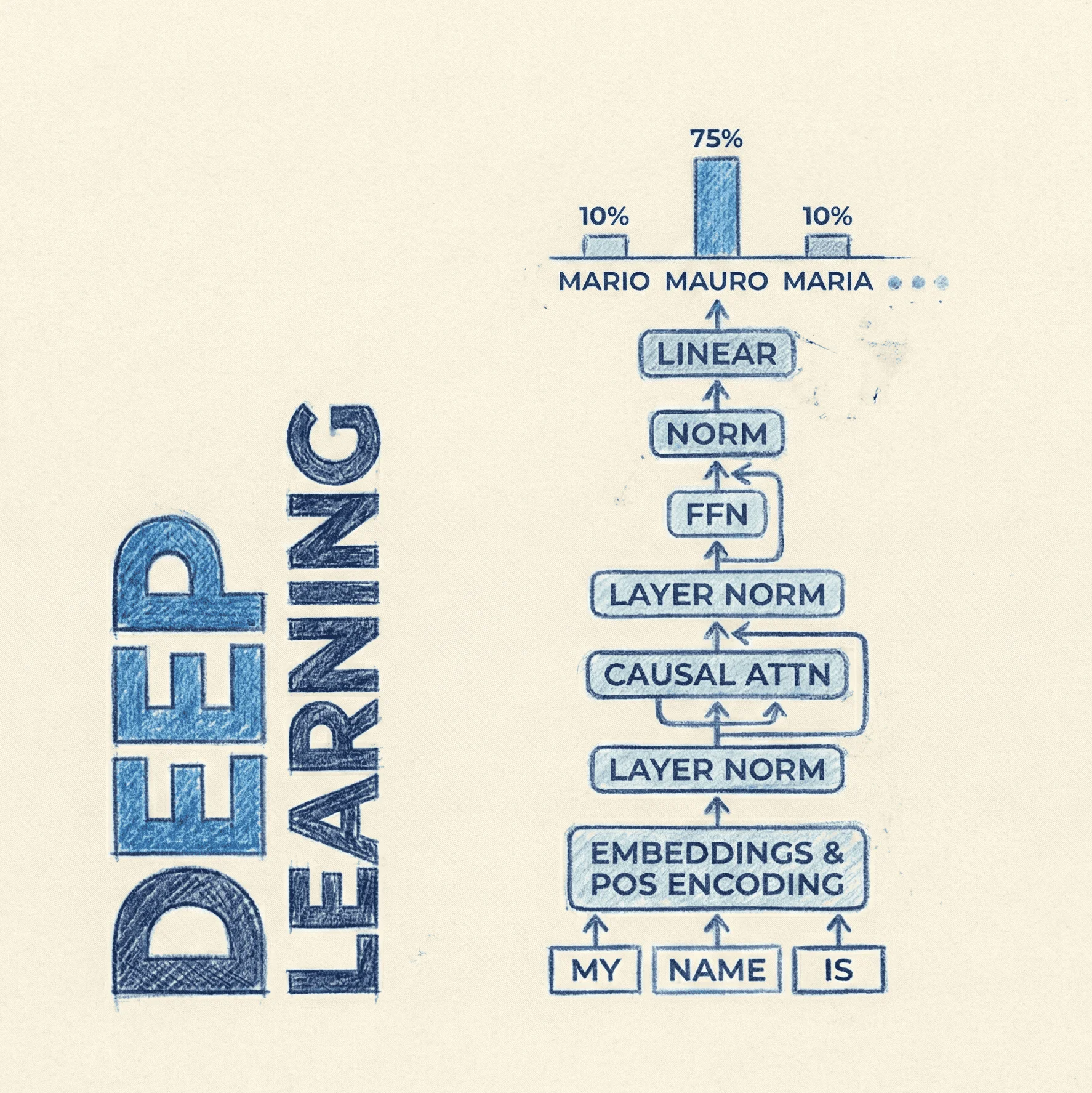

A differenza dei modelli tradizionali "densi" (come le prime versioni di Llama o GPT-2), dove ogni parte del cervello viene interpellata per ogni input, Sigma-MoE-Tiny usa un "router" intelligente per scegliere chirugicamente quale piccolo pezzo di rete neurale utilizzare. Il risultato è un modello che ha la velocità di un Tiny LM ma la qualità di risposta di modelli molto più grandi.

Perché Sigma-MoE-Tiny è rilevante oggi?

Il settore dell'IA open source si sta spostando dalla pura potenza (modelli giganti impossibili da eseguire a casa) all'efficienza (modelli potenti che girano su laptop o smartphone). Sigma-MoE-Tiny spinge questo concetto all'estremo introducendo una granularità finissima: utilizza fino a 96 "esperti" diversi per strato, ma ne attiva soltanto uno per token.

Questa è un bel cambio tecnico perché, storicamente, addestrare modelli così "sparsi" (dove si usa pochissimo del modello alla volta) era instabile e portava a risultati mediocri. Sigma-MoE-Tiny dimostra che con le giuste tecniche di "routing" (il modo in cui i dati vengono smistati), si può ottenere un'efficienza senza precedenti senza sacrificare la stabilità.

Come si collega Sigma-MoE-Tiny ai modelli che già conosci?

Per capire il salto in avanti, confrontiamolo con due standard del settore:

- Contro Qwen-2.5-0.5B (Denso): Qwen è un modello eccellente ma è "denso". Ha 0.5B parametri e li usa tutti, sempre. Sigma-MoE-Tiny ha lo stesso costo computazionale (0.5B attivi) ma ha accesso a una "banca dati" di parametri 40 volte più grande (20B totali), permettendogli di memorizzare molte più informazioni.

- Contro Mixtral 8x7B (MoE): Mixtral usa 8 esperti e ne attiva 2. Sigma-MoE-Tiny usa fino a 96 esperti e ne attiva 1. Questa "granularità fine" (Fine-Grained MoE) permette una specializzazione molto più precisa: invece di avere un esperto generico per "scienze", potresti avere un esperto solo per "chimica organica".

Link alle risorse:

- GitHub: [Non disponibile]

- Paper: arXiv:2512.16248

- Dataset: [Non disponibile - genericamente "high-quality corpus"]

Sigma-MoE-Tiny spiegato più in dettaglio

Architettura e Router

Il cuore di Sigma-MoE-Tiny risiede nel suo nome: Sigma. La maggior parte dei modelli MoE utilizza una funzione chiamata Softmax per decidere quale esperto attivare. La Softmax mette gli esperti in competizione tra loro (la somma delle probabilità deve fare 1), il che spesso porta al problema del "collasso": il modello impara a usare sempre gli stessi 2-3 esperti forti e ignora gli altri 90.

Sigma-MoE, invece, utilizza una funzione Sigmoide. Questo permette a ogni esperto di essere valutato indipendentemente. Il router non dice "Chi è il migliore tra voi?", ma chiede a ogni esperto: "Sei adatto a questo token? Sì/No". Questo approccio riduce drasticamente la competizione distruttiva tra esperti e permette quella che viene definita "High Sparsity": avere tantissimi esperti (96) ma attivarne pochissimi (1) senza perdere il segnale.

La Sfida: Il Load Balancing nei livelli inferiori

Il report tecnico evidenzia un problema critico scoperto dai ricercatori: quando si cerca di attivare solo 1 esperto su 96 (top-1 routing), i primi strati della rete neurale (i lower layers) faticano a distribuire il lavoro. Tendono a sovraccaricare alcuni esperti e lasciarne altri disoccupati, rendendo inutile la grande capacità del modello. Le classiche "auxiliary loss" (penalità matematiche usate per forzare l'equilibrio) si sono rivelate inefficaci in questo scenario estremo.

Soluzione: Progressive Sparsification Schedule

L'innovazione principale del paper è una tecnica di training chiamata Progressive Sparsification Schedule (Programmazione Progressiva della Sparsità). Invece di forzare il modello a usare un solo esperto fin dal primo giorno di scuola, il training avviene in due fasi:

- Fase Iniziale: Nei primi strati, il modello è autorizzato ad attivare più esperti (è più "denso"). Questo aiuta il segnale a fluire e stabilizza l'apprendimento.

- Fase Finale: Man mano che il training avanza, il sistema "spegne" progressivamente gli esperti extra, costringendo il modello a diventare sempre più selettivo, fino ad arrivare alla configurazione target di 1 solo esperto attivo per token.

I test hanno mostrato che convertire il modello alla sparsità target verso la fine del training preserva quasi intatte le performance (MMLU score ~63.5%) ma riduce i parametri attivi del 25% rispetto a non farlo.

Confronto con le baseline

Nonostante sia un modello "Tiny" in termini di calcolo (0.5B attivi), Sigma-MoE-Tiny compete con modelli che richiedono molte più risorse.

- Efficienza: Attivando solo 0.5B parametri, può girare velocemente su dispositivi edge (come telefoni moderni) con latenze minime.

- Qualità: I benchmark preliminari (es. MMLU) lo posizionano al livello di modelli con molti più parametri attivi. La capacità di attingere a 20B parametri totali gli conferisce una "world knowledge" (conoscenza del mondo) superiore a quella di un semplice modello da 0.5B denso.

Limiti e punti aperti

Non è tutto oro quel che luccica. L'architettura comporta alcune sfide:

- Memoria RAM: Anche se il calcolo è leggero (0.5B), il modello deve comunque tenere in memoria (VRAM) tutti i 20B parametri. Questo significa che non serve una GPU potente per fare i calcoli, ma ne serve una (o un sistema con RAM unificata) con molta capacità di archiviazione (circa 40GB in FP16, o 10-12GB se quantizzato pesantemente).

- Complessità del codice: Gestire 96 esperti richiede un codice di inferenza specializzato (kernel ottimizzati) per non perdere i vantaggi teorici nella pratica.